论文:Scalable Multi-Hop Relational Reasoning for Knowledge-Aware Question Answering

EMNLP2020的一篇论文,涉及Multi-Hop Reasoning,有代码

pdf:https://arxiv.org/abs/2005.00646

github:https://github.com/INK-USC/MHGRN

0. Abstract

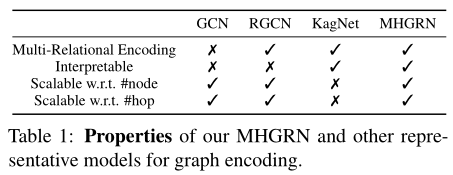

目前基于知识图谱的问答系统模型,要么缺乏多跳推理能力,要么推理方法缺乏可解释性(痛点!)

本文提出了一种方法,把预训练语言模型pre-trained language models, PTLMS和一个名为多跳图关系网络 multi-hop graph relation network, MHGRN的多跳关系推理模块相结合,实现知识图谱子图的多跳、多关系推理

该模块将基于路径的模型与基于图神经网络的模型相结合,实现了较好的可解释性和可用性,同时,具有很好的可扩展性

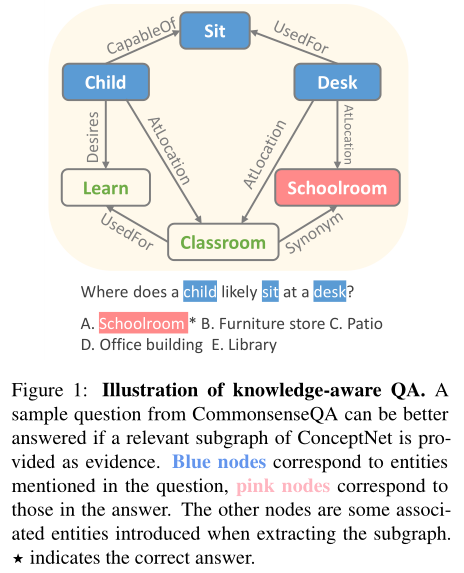

1. Introduction

目前预训练语言模型PTLMS尽管具有很好的性能,但没办法提供可解释预测,因为训练时语料库的知识就没有标明,是一种黑盒

因此,训练时就标明知识的方法,以基于知识图谱的问答系统为代表,提高了可解释性

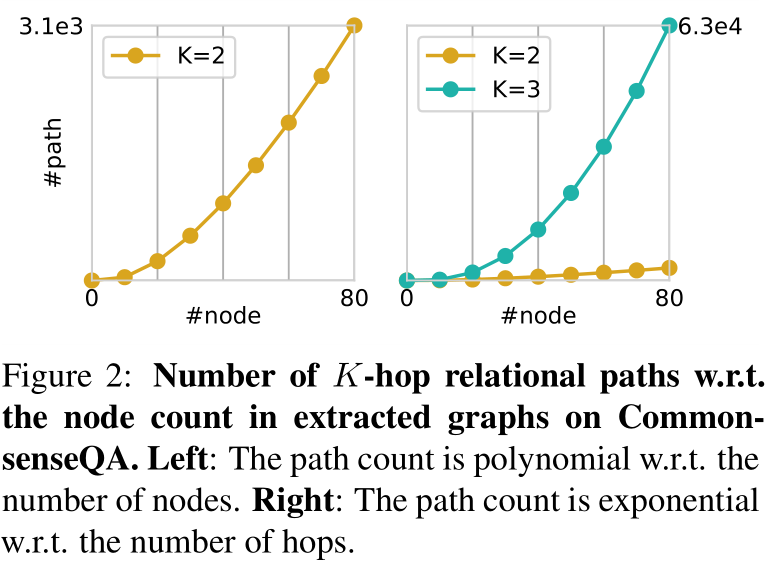

基于知识图谱的方法,一个方法是基于路径建模的方法,但这种方法的难点在于剪枝,很多现有模型是限制分支数量和跳数实现模型,降低了准确率

另一个可行的方法是基于图神经网络的方法,这种方法可扩展性很强,但缺乏可解释性和透明度(属于一种图嵌入)

本文提出的多跳图关系网络MHGRN结合了两种方法,还通过结合结构化的关系注意力机制,令基于路径建模的方法具有可解释性。

本文贡献包括:

- 提出

MHGRN,结合了基于路径建模的方法和基于图神经网络的方法,实现多跳推理 - 提出一种结构化关系注意力机制,用于高效可推理建模多跳推理路径

- 在两个问答数据集上取得SOTA

2. Problem Formulation and Overview

这里分析了一些比较常规的内容

状态向量s = [q;a]

子图G = (V,E,φ)

标记函数φ(i) ∶ V → T = {E q ,E a ,E o },三种实体分别表示问题实体、答案实体和其他实体

3. Background: Multi-Relational Graph Encoding Methods

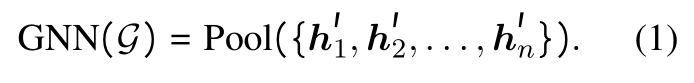

采用GNNs的图嵌入

采用GNNs的图嵌入具有良好的可扩展性,但因为是节点级的推理,所以和路径不兼容,无法实现路径级推理

- (1):基于图神经网络获取图嵌入

- (2):RGCNs模型隐含层计算公式,区别于GCNs在于不仅仅计算最近邻关系,还能计算其他多跳关系

采用基于路径模型的图嵌入

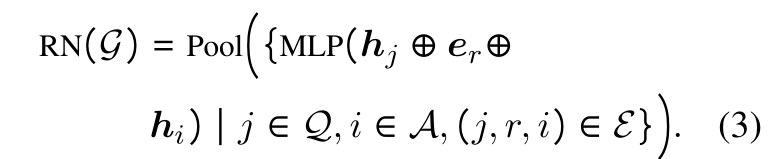

- (3):RN模型图嵌入方法,采用多层感知机,编码所有单跳三元组

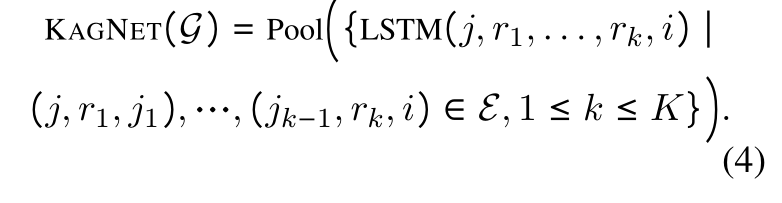

- (4):KagNet模型图嵌入方法,采用LSTM,编码所有路径,通过注意力机制聚合路径

4. Proposed Method: Multi-Hop Graph Relation Network (MHGRN)

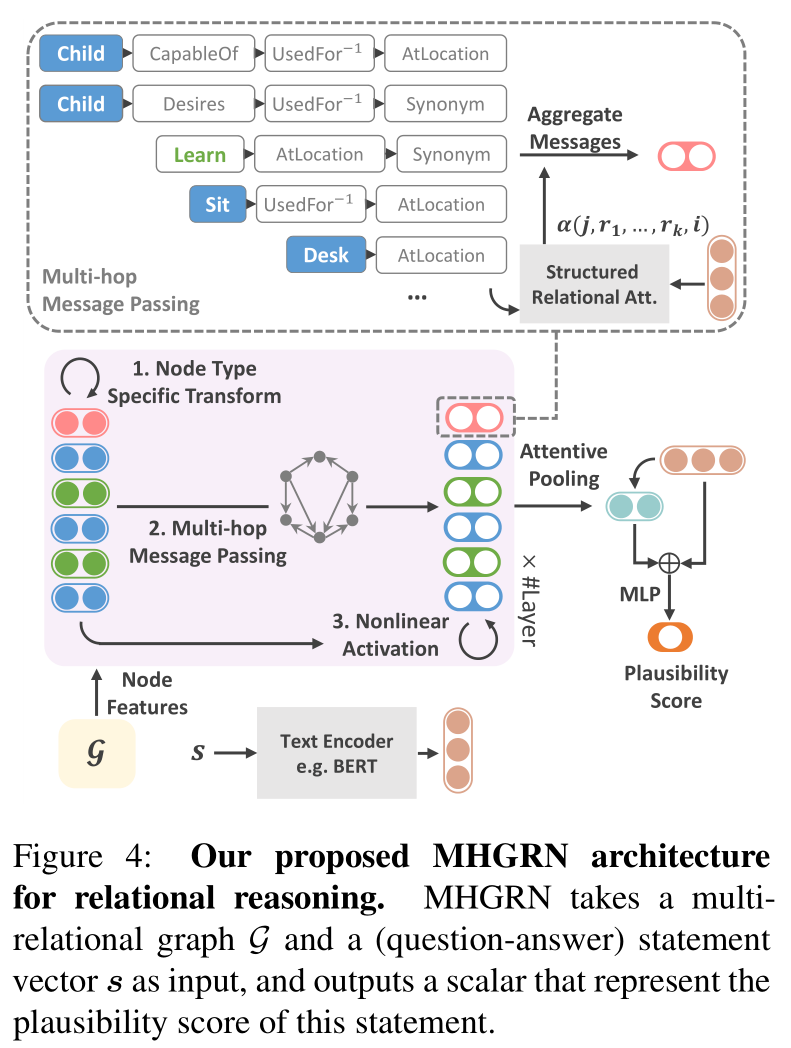

4.1 MHGRN:模型架构

模型输入是一个图和问答状态向量,输出状态向量可能性评估

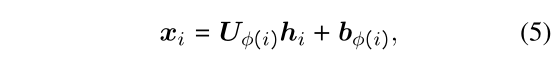

特定类型转换

为了训练模型获取节点类型φ的能力,构建各个类型节点特定的线性映射模型

- (5):类型节点特定的线性映射模型,

U和b是学习参数,根据节点类型而定

多跳信息传递

为了实现GNNs直接建模路径的能力,输入K跳的路径,在RGCNs模型中传播

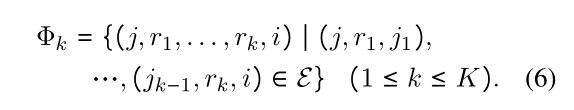

- (6):

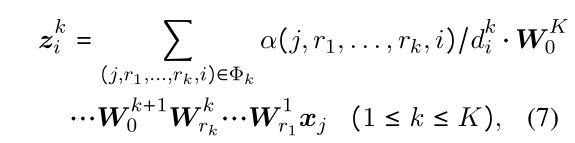

K跳路径表示 - (7):信息传播,其中

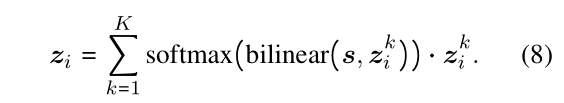

α为注意力机制,di为归一化因子 - (8):来自不同长度路径的传入信息通过注意力机制聚合

非线性激活

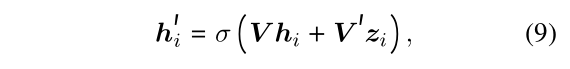

最后,实现节点嵌入

- (9):应用跳远链接

shortcut connection(RGCN术语)和非线性映射函数实现节点嵌入

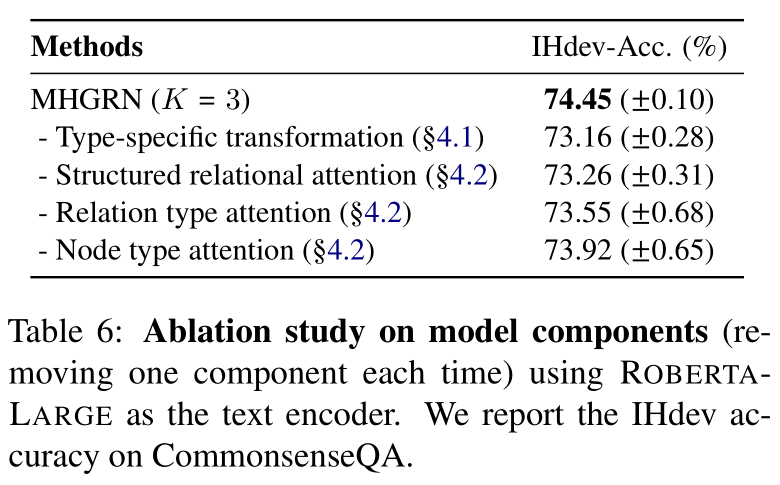

4.2 结构化关系注意

目标是生成所有k跳路径的注意力得分,而不用过多参数

这里可以重点研究代码部分

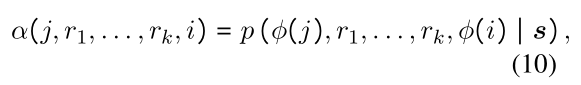

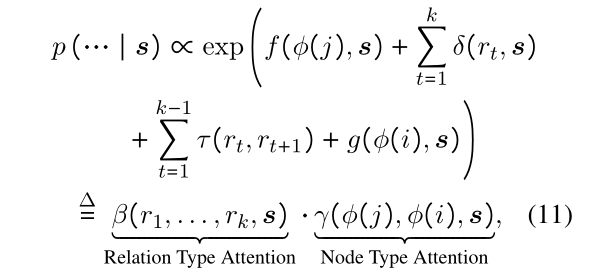

- (10):注意力得分,可以被认为是概率图网络

- (11):具体计算公式,其中

f(⋅) , δ(⋅) and g(⋅)是双层感知机的参数,τ(⋅)是状态转移矩阵,β(⋅)是k跳关系重要性,γ(⋅)是节点间信息传递重要性。上下文感知δ和双跳关系τ中,双跳关系十分重要,没有它可能会导致注意力得分出错

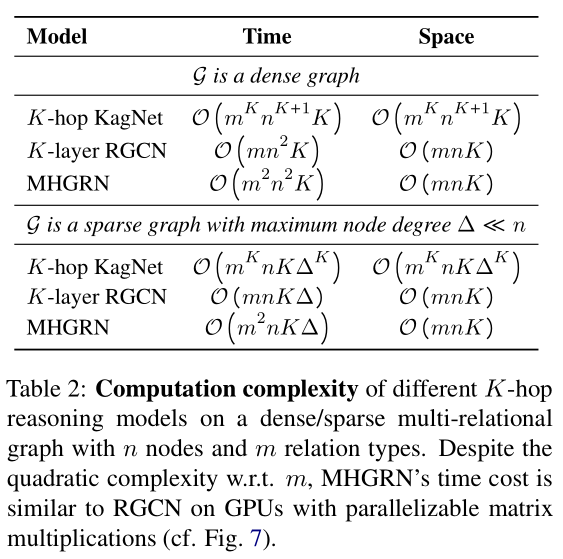

4.3 计算复杂性分析

MHGRN和RGCN具有类似的时间复杂度,可并行化处理

在(7)和(11)上的计算都是线性时间复杂度

4.4 MHGRN表达能力

MHGRN通过多跳信息传递和特定类型转换,实现了对RGCNs的扩展,使它能对路径建模

为了证明这点,构建了K跳RN模型,并证明了MHGRN能够对它进行表示

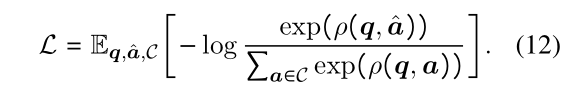

4.5 学习、推理和路径解码

学习训练是通过多分类任务实现的,基于文本嵌入RoBERTa实现了端到端训练

推理和路径解码是通过(8)实现的,可能性最大的路径和节点具有最高分数。可以通过动态规划在线性时间内完成计算

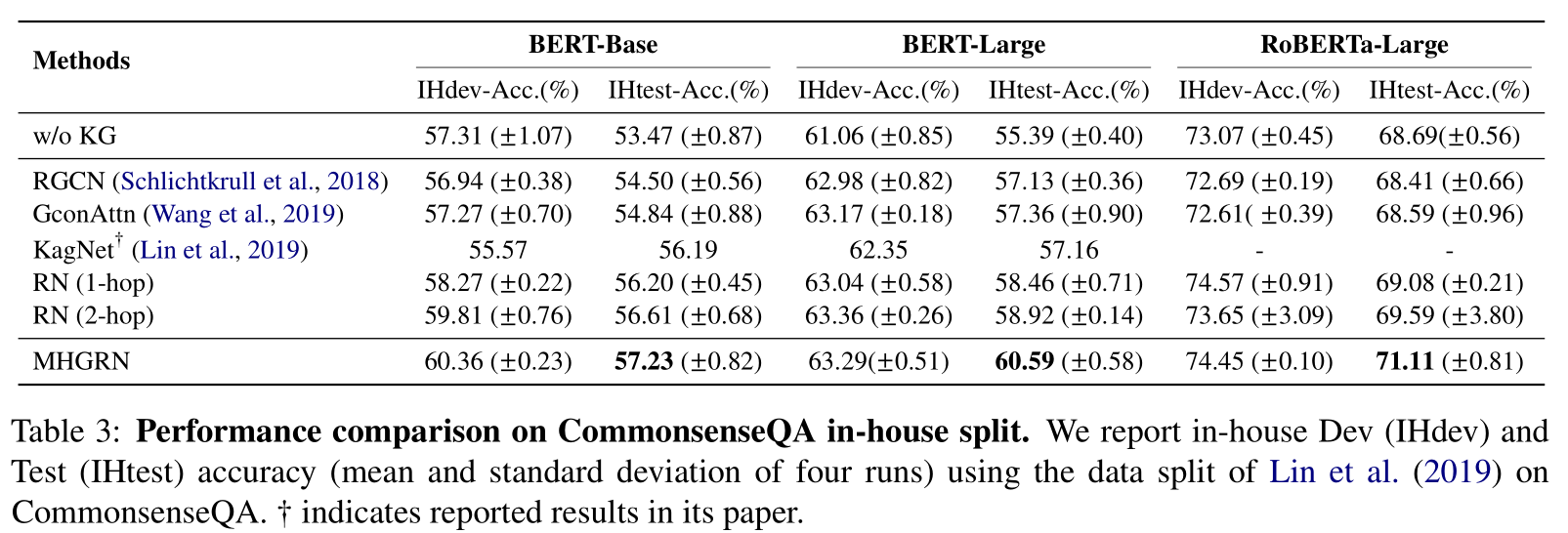

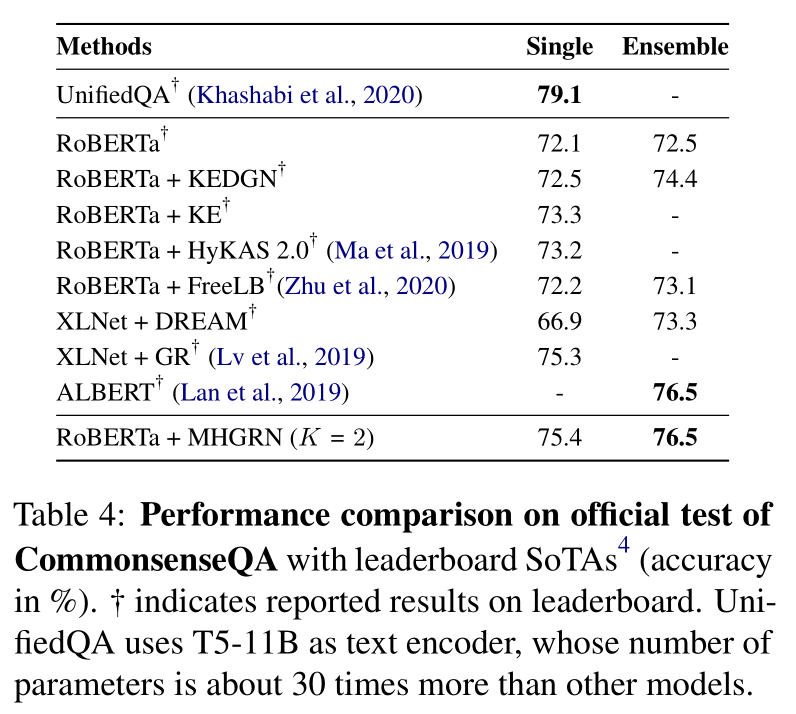

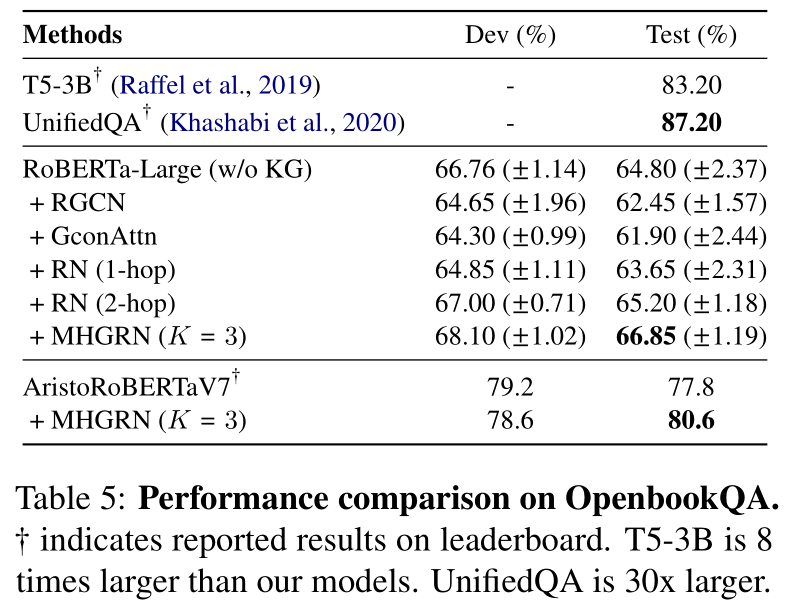

5. Experimental Setup

5.1 从外部知识图谱中提取图

使用ConceptNet(一种通用领域知识图谱)作为外部知识图谱。模仿KagNet,合并关系类型以增加图密度,并添加反向关系以构建多关系知识图谱。预训练模型采用RoBERTa,实现了预训练语言模型知识和外部知识图谱知识的结合

5.2 数据集

CommonsenseQA:需要常识推理,基于ComceptNet知识图谱OpenbookQA:同样需要常识推理

5.3 比较方法

预训练语言模型类型:

BERT-BASEBERT-LARGERoBERTa

基于路径建模的类型:

6. Results and Discussions

6.1 主要结果

6.2 性能分析

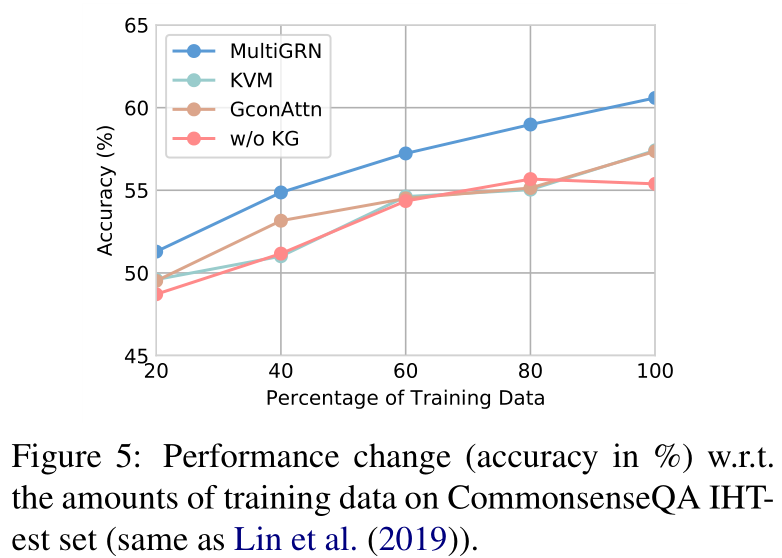

训练数据量影响

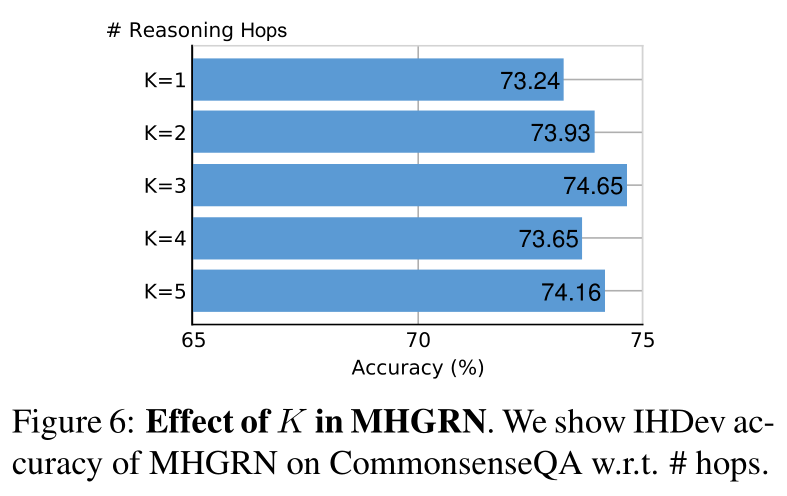

跳数影响

6.3 模型可扩展性

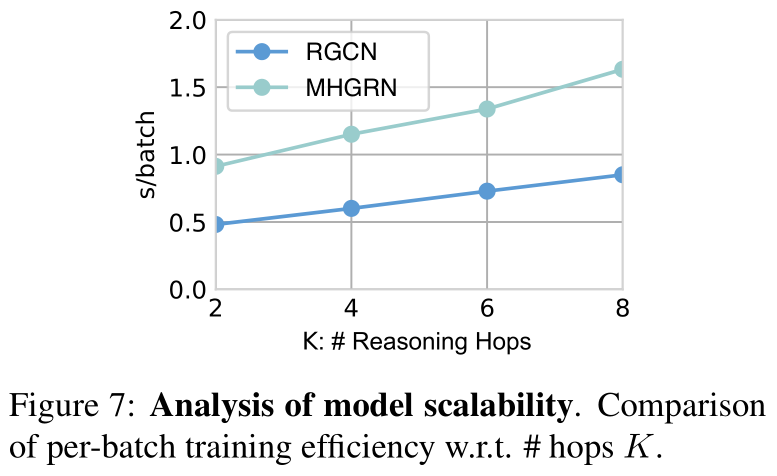

MHGRN扩展性较RGCN略差,但可以通过并行化解决问题

6.4 模型可解释性

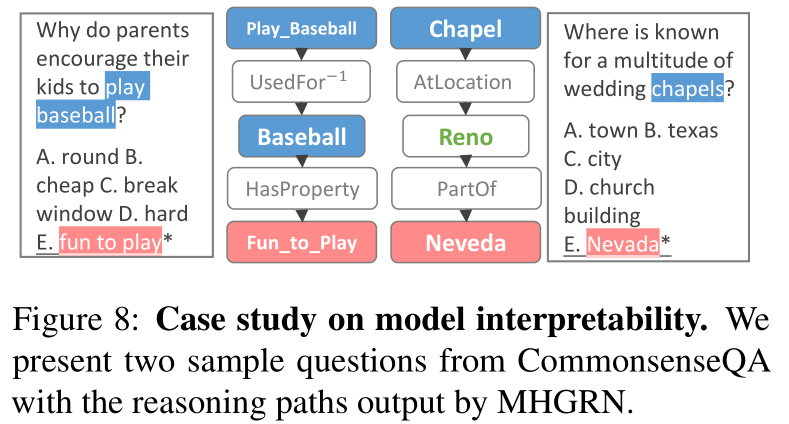

MHGRN能正确回答问题,并提供推理路径

7. Related Work

8. Conclusion

本文提出一种多跳问答方法MHGRN,其可扩展性和可解释性超越了目前的方法

论文分析

本篇论文介绍非常清晰,并且探讨了一个新的思路,和我近期思路比较类似:将嵌入方法与路径方法相结合,从而综合提高可解释性和可行性。可以在本文的工作上做些文章

Comments | NOTHING